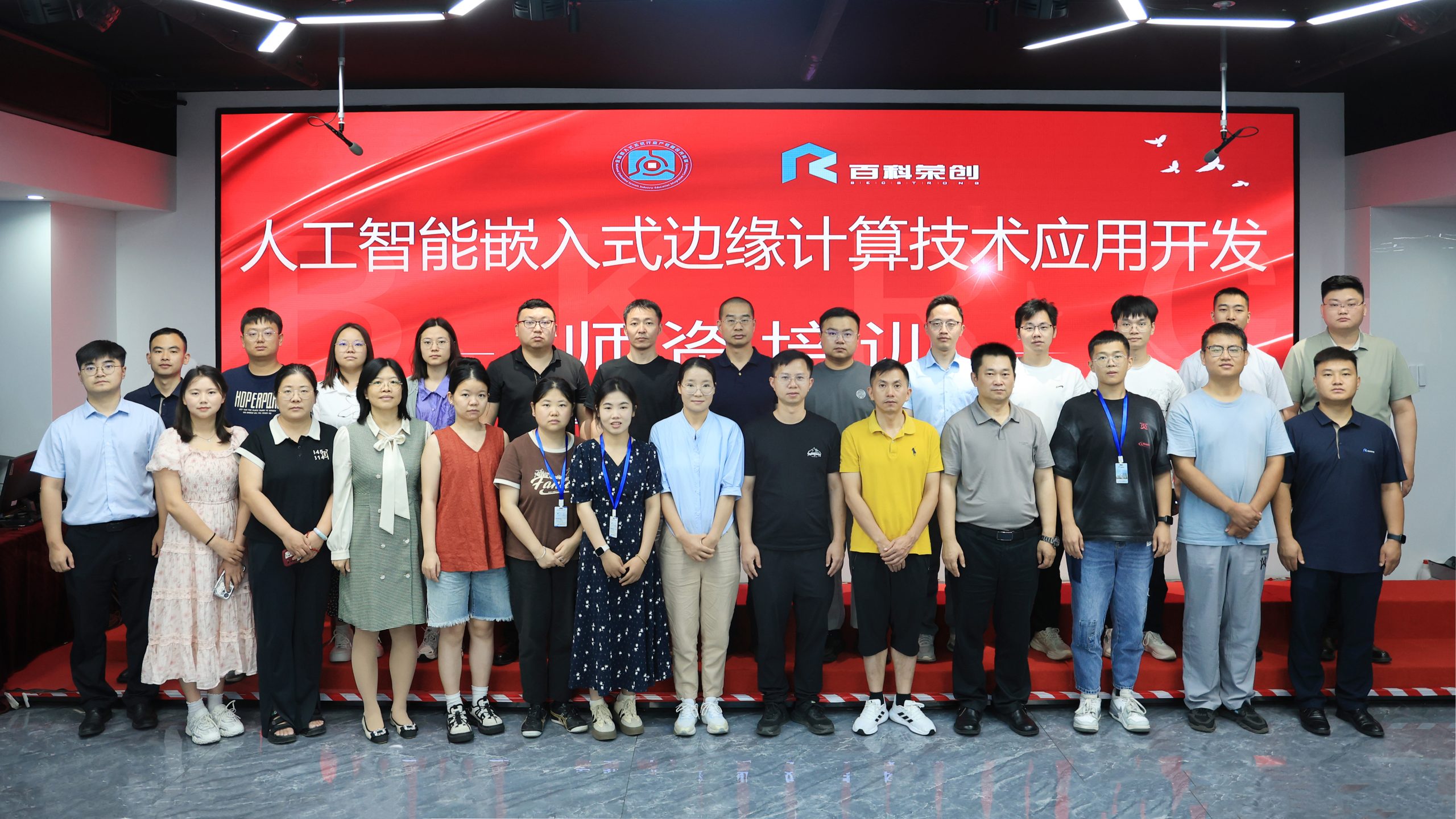

参加百科荣创2025年度暑期教师培训总结

——人工智能学院 陈小强

今年夏天,我有幸深度参与了由百科荣创主办的“人工智能嵌入式嵌入式边缘计算技术应用开发师资培训”。这并非一次泛泛而谈的理论讲座,而是一场深入到架构、算法模型与工程实践的“硬核”征途。作为一名长期从事人工智能领域教学与科研的教师,这次培训是从理论认知到动手实践的一次关键跃迁,让我对嵌入式AI技术全貌与教学实现路径有了清晰的理解,现将本次培训的技术核心与心得体会总结如下。

一、核心硬件剖析,深入理解AIoT的“心脏”

本次培训的起点,也是所有实验的基石,便是对BK-EAI900实验箱的核心处理器——瑞芯微RK3588S的深度剖析。培训讲师没有停留在“这是一款高性能芯片”的表面描述,而是带领我们逐层拆解其技术规格,让我深刻认识到其作为新一代AIoT平台的强大之处。

异构计算的精髓——NPU的威力。培训的重中之重,是其内置的神经网络处理单元(NPU)。手册中“算力高达6 TOPS”的参数,在培训中得到了具象化的解释。讲师阐明,TOPS(Tera Operations Per Second)是衡量AI芯片推理性能的核心指标,6 TOPS意味着该NPU每秒可执行六万亿次定点运算。这使得过去在PC上都可能卡顿的复杂神经网络模型(如YOLOv5),得以在小小的嵌入式板卡上流畅运行。我们不再是空谈AI加速,而是亲眼见证了NPU如何通过硬件级优化,将AI推理的效率提升数个数量级。

多媒体处理能力。培训还详细介绍了其强大的视频处理单元(VPU),支持8K@60fps的H.265/VP9解码和8K@30fps的H.265/H.264编码。这让我意识到,BK-EAI900不仅是一个AI计算平台,更是一个完整的高清视觉系统解决方案,为开发复杂的视频分析、智能监控等应用打下了坚实的硬件基础。

丰富的硬件接口。在动手环节,我们熟悉实验箱上的各类接口,用于连接高清摄像头的MIPI-CSI、连接显示屏的MIPI-DSI和HDMI、高速数据传输的USB 3.0、稳定的有线网络连接的千兆以太网口,以及用于底层硬件控制的GPIO阵列。还亲自操作了板载的温湿度、光照、红外等传感器,以及LED、蜂鸣器等执行器。这种对硬件资源的全面掌握,是后续一切软件开发和算法实践的前提。

二、软件生态与工具链,打通从模型到部署的“最后一公里”

如果说RK3588S是强健的骨骼,那么百科荣创提供的软件栈和工具链就是贯通全身的经络。本次培训系统地梳理了在Ubuntu 20.04操作系统下,使用Python和Jupyter Lab进行开发的全流程。

我们学习到,要真正发挥NPU的性能,关键在于掌握RKNPU2驱动。它作为应用层与NPU硬件之间的桥梁,提供了Python API,让我们可以通过简洁的代码调用底层强大的AI算力。同时,RKNN-Toolkit2工具套件是本次培训的又一核心。我们花了大量时间学习和实践它的工作流程:如何将一个在PC上用主流框架(如PyTorch、TensorFlow、ONNX)训练好的模型,通过RKNN-Toolkit2进行模型转换、量化和优化。我深刻理解到,这一步是嵌入式AI部署中至关重要的一环。它将庞大的浮点模型(FP32)转换为适合在NPU上高效运行的定点模型(如INT8),在几乎不损失精度的前提下,极大提升推理速度、降低内存占用。

培训强调了各个库之间的协同工作。我们学习了如何使用libcamera库来配置和控制摄像头,获取原始图像流;然后,利用无处不在的OpenCV库对图像进行预处理,如缩放(resize)、颜色空间转换(cvtColor)、归一化等,使其符合AI模型的输入要求;当NPU完成推理后,再使用OpenCV将结果(如边界框、关键点)可视化地绘制在图像上。这种模块化的协同开发模式,是构建复杂视觉应用的工业标准。

三、实验内容递进,从点亮LED到构建智能门禁

本次培训的实验设计堪称典范,其由浅入深、层层递进的结构,完美符合认知规律,让我和同行的老师们能够平滑地攀登嵌入式AI的技术高峰。

1.基础感知与控制阶段。我们从最基础的Linux命令和Python语法复习开始,迅速过渡到GPIO编程。当亲手写下几行代码,通过成功点亮一颗LED、驱动蜂鸣器、读取按键状态时,那种将软件指令转化为物理世界响应的成就感,是任何纯理论学习都无法比拟的。随后,我们读取了各类传感器数据,并在OLED小屏幕上实时显示,完成了对环境的数字化感知。

2.计算机视觉入门阶段。中级实验的核心是“看懂世界”。我们调用摄像头,成功采集并显示了实时视频流。接着,利用OpenCV强大的图像处理函数,我们对图像进行了滤波、二值化、形态学操作等一系列经典处理。最终,我们成功地在视频流中实现传统的人脸检测算法,为后续的AI应用打下视觉处理的基础。

3.挑战前沿的YOLOv5目标检测。如果说人脸识别是经典应用,那么部署YOLOv5则让我们触摸到了业界的前沿。我们学习了YOLO(You Only Look Once)算法的基本原理,并亲手将庞大的YOLOv5模型成功移植到BK-EAI900上。看着屏幕上实时检测出行人、车辆、交通标志等数十种物体,且帧率(FPS)表现优异,我深刻体会到,一个强大的嵌入式AI平台,能够将过去停留在论文和云端的先进算法,真正落地到边缘设备上。

4.综合项目——智能门禁系统。最后的综合项目是将所有知识融会贯通的实战演练。我们小组协作,整合了摄像头采集、NPU人脸识别、OLED信息显示、GPIO控制(用LED灯的亮灭模拟门锁的开关),成功构建一个功能完备的智能门禁原型。这个过程不仅巩固了技术细节,更培养了我们系统设计和工程实现的能力。

四、 总结与教学展望

此次百科荣创的培训,是一次彻底的技术赋能。它不仅让我掌握了BK-EAI900这一具体实验平台的使用方法,更重要的是,它让我完整地走通了“硬件选型 -> 系统环境搭建 -> 软件驱动 -> 模型转换与优化 -> 算法部署 -> 系统集成”这一嵌入式人工智能项目的全链路。

回到教学岗位,我的思路豁然开朗。过去,我向学生讲授人工智能,更多是基于PC端的Python编程和理论介绍,学生离真实的硬件和产品级应用总有一层隔阂。现在,借助BK-EAI900这样的平台,我可以设计出更具吸引力和挑战性的课程:

1.开设《嵌入式人工智能》或《AIoT系统实践》等新课程,让学生亲手在RK3588S上部署自己的AI模型。

2.改革现有的《计算机视觉》实验,引入基于NPU加速的实时处理项目,替代传统的基于CPU的慢速演示。

3.指导学生的毕业设计和科创项目,鼓励他们利用该平台开发如智能巡检小车、垃圾分类机器人、自动化农业监测等具有现实意义的作品。

总而言之,本次培训为我打开了一扇通往“真刀真枪”的AI工程实践大门。不仅学到了知识,更收获了将前沿科技转化为育人资源的信心与方法。由衷感谢百科荣创提供的这次宝贵机会,我将把所学、所思、所感带回课堂,努力为国家培养更多具备全栈工程能力的嵌入式AI人才。

江西省教育厅|

江西省人社厅|

江西省职业教育与成人教育网|

技能人才评价网|

中国高职高专教育网|

职业教育国家教学标准体系|

Copyright @ 2025 人工智能技能大师工作室 版权所有 ICP备案编号:赣ICP备2024034540号-1No:30108

地址:江西省吉安市吉州区吉安南大道133号 电话:15270169682